在程序化交易中,K线数据作为最基础、最核心的市场信息载体,其处理的质量直接决定了策略的成败。本文将浅谈程序化交易中K线数据处理的关键环节与核心考量。

一、K线数据的获取与清洗

程序化交易的第一步是获取准确、及时的原始K线数据。数据来源通常包括交易所、第三方数据服务商或经纪商API。获取数据后,清洗工作至关重要。这包括:处理缺失值(如前复权导致的跳空)、识别并修正异常值(如因网络延迟或报价错误产生的“毛刺”)、统一数据格式与时间戳。清洗后的数据应保证时序的连续性、价格的合理性以及量价关系的逻辑自洽,为后续分析奠定坚实基础。

二、K线数据的转换与合成

原始数据往往是最细颗粒度的分笔或分钟数据。根据策略需求,需要将其合成为特定周期的K线(如5分钟、1小时、日线)。合成过程需严格遵循时间规则与价格要素(开、高、低、收、量、额)的计算逻辑。尤其需注意不同交易所或品种的交易时间、节假日差异。高级应用还包括生成Heikin-Ashi(平均K线)、Renko(砖形图)等特殊K线,以过滤市场噪音,更清晰地展现趋势。

三、特征工程的构建

这是数据处理的核心,旨在从原始K线中提炼出对策略有预测或解释能力的特征。主要包括:

1. 技术指标:如移动平均线(MA)、布林带(BB)、相对强弱指数(RSI)、MACD等。计算时需注意参数选择、初始值处理(如滚动窗口的填充)及计算效率。

2. 统计特征:如收益率、波动率、偏度、峰度、自相关性等,用于刻画市场的统计特性。

3. 形态识别:通过模式匹配算法识别如“锤子线”、“吞没形态”等经典K线组合。

4. 衍生特征:如价量关系(量价齐升)、跨周期关系(日线趋势中的分钟线信号)、跨品种价差等。特征工程要求兼具金融逻辑与计算可行性。

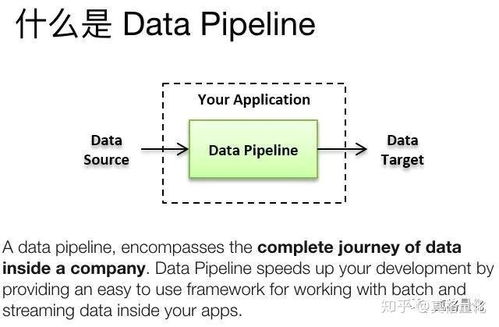

四、数据存储与访问优化

海量历史K线数据与实时数据流对存储和检索效率提出挑战。常见的方案包括使用时序数据库(如InfluxDB)、关系型数据库的分区表,或高效的文件格式(如Parquet、HDF5)。在内存中,常采用环形缓冲区或高效数据结构(如pandas DataFrame)进行实时管理。优化目标是在保证数据完整性的前提下,实现毫秒级甚至微秒级的读写速度,以满足高频或中低频策略的不同需求。

五、回测与实盘的数据一致性

这是程序化交易中最易被忽视却至关重要的环节。回测中使用的是已清洗、完整的“过去”历史数据,而实盘面对的是可能存在延迟、缺失的“当下”实时数据流。必须确保回测中的数据处理逻辑(如K线合成规则、指标计算时点、信号生成条件)与实盘交易引擎中的逻辑完全一致,避免“未来函数”和“幸存者偏差”。通常需要通过模拟实时数据流对策略进行“穿透测试”来验证一致性。

K线数据处理远非简单的数据搬运,它是一个融合了金融知识、统计学、计算机科学和工程实践的系统性工程。从数据源头的质量把控,到特征构建的创造力,再到工程实现的严谨性,每一个环节都需精益求精。唯有夯实数据处理的基石,程序化交易策略才能在海量市场信息中精准导航,实现稳定盈利的目标。